Il y a quelque temps, j’avais évoqué la manière dont l’IA agentique commence enfin à fonctionner.

Les agents IA commencent désormais à planifier, raisonner et exécuter des tâches numériques sans avoir besoin d’être constamment sollicités.

Les codeurs les utilisent pour rechercher des bugs et réécrire du code défectueux. Les vendeurs sur Amazon les utilisent pour gérer leurs stocks. L’IA agentique est même utilisée pour traiter des questions plus complexes.

Par exemple, en septembre, des chercheurs ont publié un article sur HealthFlow, un agent de recherche auto-évolutif conçu pour relever les défis de la recherche médicale.

Au lieu d’attendre une instruction humaine à chaque étape, HealthFlow planifie sa propre approche de la recherche. Il teste différentes stratégies, tire des leçons des résultats et améliore ses méthodes au fil du temps.

C’est comme un jeune chercheur qui devient plus intelligent à chaque expérience. Et lors de tests de référence, HealthFlow a surpassé les meilleurs systèmes d’IA sur certains des défis les plus difficiles en matière de données de santé.

Mais aussi passionnant que cela puisse être, ces agents IA restent des logiciels. Ils sont prisonniers du monde numérique.

Ou peut-être pas ?

Les robots font l’objet d’une mise à niveau

Le 25 septembre, DeepMind de Google a présenté Gemini Robotics 1.5.

Avec cette version, l’IA agentique fait désormais partie du monde physique.

Gemini Robotics 1.5 est en fait composé de deux modèles qui fonctionnent en tandem. Gemini Robotics ER 1.5 est un modèle de raisonnement. Il peut utiliser des outils tels que Google Search pour décomposer de grands objectifs en étapes plus petites et décider de la marche à suivre.

Gemini Robotics 1.5 est un modèle de vision-langage-action (VLA). Il prend les sous-objectifs de ER 1.5 et les traduit en mouvements concrets tels que saisir, pointer et manipuler des objets.

La combinaison des deux modèles est une nouveauté dans le domaine de la robotique…

Un système qui réfléchit avant d’agir.

DeepMind affirme que ces modèles sont conçus pour des tâches quotidiennes en plusieurs étapes, telles que trier le linge, préparer ses affaires en fonction de la météo ou recycler des objets selon les règles locales.

Ce type d’adaptabilité est la pièce manquante dans le domaine de la robotique depuis des décennies.

Les usines regorgent de machines rigides qui effectuent une seule et même action, encore et encore. Mais dès que le produit change, le robot doit être reprogrammé à partir de zéro.

DeepMind développe un robot capable de généraliser et d’apporter des modifications à la volée.

Tout aussi important, ils ont introduit le transfert de mouvement, c’est-à-dire la capacité d’enseigner une compétence une seule fois et de la partager entre différents corps de robots.

Dans une vidéo, ils ont montré un bras robotique dans le laboratoire apprenant à effectuer des tâches spécifiques. Gemini Robotics 1.5 a ensuite permis au robot humanoïde Apollo d’Apptronik de réutiliser ces connaissances sans repartir de zéro.

Image : DeepMind sur YouTube

Cela permettra aux robots d’élargir rapidement l’éventail des tâches qu’ils peuvent accomplir dans le monde réel.

C’est pourquoi DeepMind n’est pas le seul à nourrir ces ambitions.

Nvidia s’est engagé dans la même voie. Lors de la conférence GTC en mars, le PDG de Nvidia, Jensen Huang, a présenté un système appelé GR00T, qui est en quelque sorte le « cerveau » des robots humanoïdes.

Il s’agit d’un modèle de base conçu pour les aider à voir, comprendre et se déplacer davantage comme des êtres humains.

Quelques mois plus tard, Nvidia a ajouté la « force physique » en présentant Jetson Thor, un ordinateur puissant intégré au robot lui-même.

Au lieu de renvoyer chaque décision vers le cloud, il permet aux robots de réfléchir et d’agir sur place en temps réel.

Ensemble, GR00T et Jetson Thor apportent aux robots l’intelligence et les réflexes qui leur manquaient.

Amazon s’est également engagé dans cette voie. L’année dernière, l’entreprise a commencé à tester Digit, un robot humanoïde d’Agility Robotics, dans ses entrepôts.

Image : Agility Robotics

Bien que les essais restent à ce jour limités, l’ambition d’Amazon est limpide : déployer une main-d’œuvre robotisée qui ignore la fatigue et, surtout, ne revendique aucun droit syndical.

Il y a aussi Covariant, une start-up qui a lancé son propre modèle de base en robotique, le RFM-1, au début de l’année.

Les robots de Covariant peuvent suivre des instructions en langage naturel, apprendre de nouvelles tâches à la volée et même demander des éclaircissements lorsqu’ils ne savent pas quoi faire. En d’autres termes, RFM-1 donne aux robots des capacités de raisonnement similaires à celles des humains.

C’est un énorme bond en avant par rapport aux machines sans intelligence auxquelles nous sommes habitués.

Sanctuary AI construit des robots équipés de capteurs tactiles. Son objectif est de créer des machines capables de sentir ce qu’elles touchent.

C’est une capacité que les humains considèrent comme acquise, mais qui a toujours posé problème aux robots. Combinez le toucher et le raisonnement, et vous comprendrez comment les robots pourraient bientôt accomplir les tâches imprévisibles et délicates qui remplissent notre quotidien.

Mais que signifient toutes ces avancées en robotique ?

Rien de moins que ce que je martèle depuis des années.

La frontière entre logiciel et matériel s’estompe à mesure que l’intelligence numérique des agents IA fusionne avec les capacités physiques des robots.

Une fois cette frontière disparue, les possibilités seront infinies…

Et le potentiel du marché est stupéfiant.

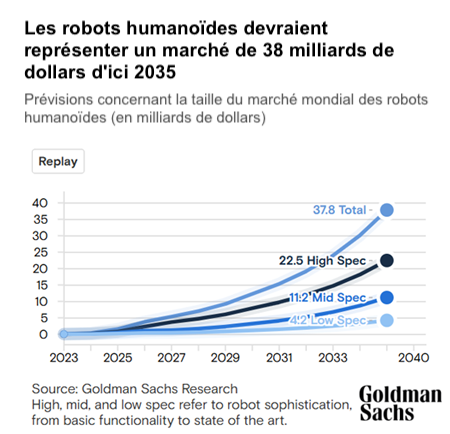

Goldman Sachs prévoit que le marché des humanoïdes à lui seul pourrait atteindre 38 milliards de dollars d’ici 2035.

L’industrie mondiale de la robotique devrait atteindre 375 milliards de dollars dans une décennie, soit plus de cinq fois sa taille actuelle.

Mon avis

Pour le moment, les coûts de construction et de maintenance de ces systèmes restent élevés.

Mais si l’histoire nous enseigne quelque chose, c’est que les percées technologiques sont rarement abouties dès leur apparition.

Vous vous souvenez certainement de l’Internet par modem, lent et peu fiable, des années 1990. Mais cela ne l’a pas empêché de devenir la colonne vertébrale de l’économie mondiale.

Je pense que c’est là où nous en sommes aujourd’hui avec la convergence de l’IA agentique et de la robotique…

Mais je m’attends à ce que les choses évoluent beaucoup plus rapidement à partir de maintenant.

À l’avenir, nous allons commencer à côtoyer des machines capables de penser et d’agir dans le même monde que nous.

Et les bouleversements qui s’ensuivront pourraient bien éclipser tout ce que nous avons connu jusqu’à présent.

Pour prendre une longueur d’avance sur cette révolution, rejoignez dès maintenant les lecteurs de Fortune Stratégique, qui sont déjà positionnés sur la robotique et les grandes méga-tendances qui façonneront notre futur.

À très vite,

Ian King